A generatív mesterséges intelligencia (GenAI) robbanásszerű elterjedése radikálisan átírja a nagy adatközpontok működését és architekturális prioritásait. Eddig a fókusz a modell betanításán volt, ahol a hatalmas GPU klaszterek domináltak, de a valódi kihívás – és a valódi pénz – az inferencia (a modell futtatása) fázisában van, ami a teljes számítási terhelés 80-90%-át teszi ki. Ez a tömeges igény új frontot nyitott a szilíciumháborúban, ahol a hagyományos CPU-k és még a GPU-k is komoly hatékonysági deficitbe kerülnek.

A generalista gpu alkonya?

Évekig az NVIDIA Cuda ökoszisztémája volt a vitathatatlan királya a mélytanulásnak, köszönhetően a párhuzamos feldolgozási képességeknek. A GPU-k azonban, lévén generalista, sokoldalú gyorsítók, rengeteg felesleges funkcionális egységet és nagy memória-sávszélességet is magukkal cipelnek, amelyek feleslegesek az inferencia fázisában. Ha egy betanított modellt futtatunk, a lényeg a latency és a throughput optimalizálása, nem feltétlenül a lebegőpontos számítások abszolút pontossága, ami a betanításnál kritikus.

A generalista architektúra legnagyobb hátránya az energiahatékonyság, különösen, ha alacsonyabb precizitású (pl. INT8, vagy akár bináris) számításokat végzünk. Emiatt a TCO (Total Cost of Ownership) elszáll, hiszen az áramszámla és a hűtési igények exponenciálisan növekednek a GPU-k skálázásával. A hiperszkéler szolgáltatók számára, akiknek dollármilliárdokat kell megtakarítaniuk a futtatási költségeken, ez a hatékonysági rés elfogadhatatlan.

A szilíciumtervezők ezért egyre inkább a „just-in-time” inferencia motorokra koncentrálnak, amelyek elhagyják a generalista GPU-k overheadjét. Ez a tendencia ássa alá az NVIDIA pozícióját az inferencia piacon, ahol a nagy vásárlók már nem hajlandóak a drága, túlzottan sokoldalú hardverért fizetni, ha a feladat specifikusan optimalizálható.

A domain-specifikus gyorsítók forradalma

A hatékonyság maximalizálásának kulcsa a domain-specifikus architektúrák (DSA) alkalmazása, amelyek a neurális hálózatok futtatásának sajátosságaira vannak szabva. A legismertebb példa erre a Google Tensor Processing Unit (TPU), amelyet kifejezetten a TensorFlow és más ML keretrendszerek mátrixszorzási igényeire optimalizáltak. A TPU-k kihasználják a nagy hálózatok sparsity (ritkaság) jellemzőit és a fixpontos aritmetikát.

A TPUs mellett egyre több startup is piacra dob ASIC (Application-Specific Integrated Circuit) megoldásokat, amelyek csak egyetlen feladatra, az inferenciára fókuszálnak. Ezek a chipek sokkal kisebb lábnyommal és fogyasztással rendelkeznek, miközben azonos throughputot képesek biztosítani, mint a többszörös GPU-k. A kritikus pont az, hogy ezek az ASIC-ek elhagyják a programozhatóságot a nyers sebesség és energiahatékonyság kedvéért.

Egy másik, ígéretes alternatíva a Reconfigurable Computing, azaz az FPGA-k (Field-Programmable Gate Array) használata. Ezek a chipek lehetővé teszik a hardver architektúra utólagos, szoftveres konfigurálását, ami ideális a gyorsan fejlődő AI modellekhez. Bár az FPGA-k latency-je általában magasabb, mint az ASIC-eké, rugalmasságuk felbecsülhetetlen, különösen a ritkán változó, de nagy volumenű inferencia terheléseknél.

A diszaggregált infrastruktúra ígérete

A hagyományos szerver architektúrában a CPU, a memória és a gyorsítók (GPU, TPU) szorosan a szerverhez vannak kötve. Az inferencia terhelések dinamikus és változó természete azonban megköveteli a rugalmasságot, ami a diszaggregált infrastruktúrát (Composability) helyezi előtérbe. Ez azt jelenti, hogy a számítási, memória- és gyorsítóerőforrásokat poolokba szervezik, és igény szerint allokálják a feladatokhoz.

Ennek a paradigmaváltásnak egyik kulcsa a CXL (Compute Express Link) protokoll, ami lehetővé teszi a CPU-k, memóriák és gyorsítók koherens összekapcsolását ultraalacsony latency mellett. A CXL segítségével például egyetlen inferencia feladat több, dedikált AI gyorsító erőforrását is felhasználhatja anélkül, hogy az adatoknak át kellene utazniuk a lassabb PCIe buszon.

A diszaggregáció nem csak a hatékonyságot növeli, hanem drámaian csökkenti a hardverkihasználatlanságot. Ha egy adott szerver éppen nincs kihasználva, a benne lévő AI gyorsító azonnal átadható egy másik szervernek, ami éppen inferencia spike-ot tapasztal. Ez a rugalmasság elengedhetetlen a GenAI szolgáltatások gazdaságos üzemeltetéséhez.

Energiahatékonyság és a TCO dilemma

Az inferencia-optimalizálás végső célja a TCO, azaz a teljes birtoklási költség drasztikus csökkentése. Amikor több millió felhasználó kérdez le egy LLM-et (Nagy Nyelvi Modell) másodpercenként, minden megtakarított watt óriási pénzügyi előnyt jelent. A DSA chipek (ASIC/TPU) itt nyernek a GPU-kkal szemben, mivel a Watt/TFLOPS (vagy TOPS) arányuk nagyságrendekkel jobb.

A szakértői becslések szerint a nagy LLM-ek (például egy GPT-4 méretű modell) inferencia költségei a következő öt évben 50-70%-kal csökkenhetnek, kizárólag a specializált hardverek és a kvantizációs technikák (pl. 4-bites súlyok) miatt. Ez a költségcsökkenés teszi lehetővé, hogy az AI szolgáltatások szélesebb körben, alacsonyabb áron legyenek elérhetőek, ami tovább pörgeti a fejlesztési ciklust.

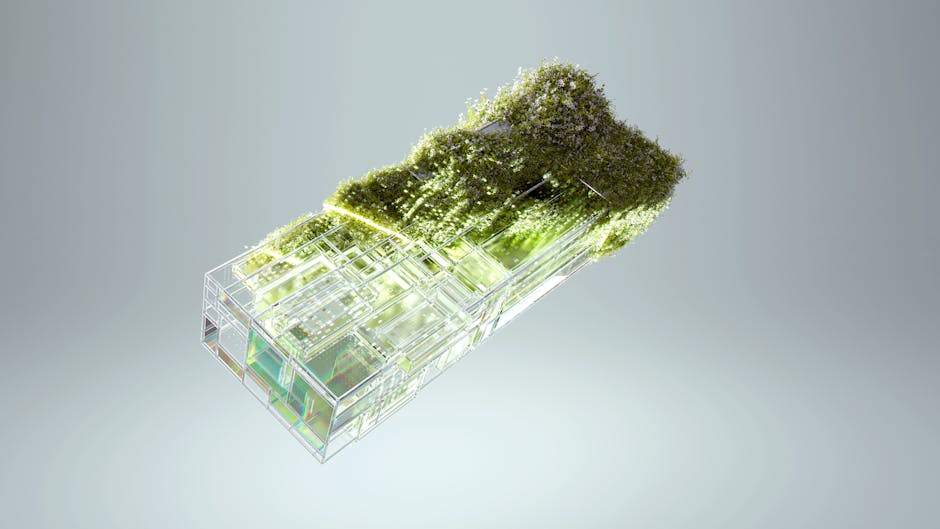

A jövő adatközpontja tehát nem egy homogén GPU-mező lesz, hanem egy heterogén környezet, ahol a CPU a vezérlő, a memória diszaggregált, és a számítási feladatokat (betanítás, inferencia, HPC) a legmegfelelőbb, leginkább energiahatékony, dedikált gyorsító végzi el. Ez az architekturális váltás a kulcsa annak, hogy az AI ne csak luxusszolgáltatás, hanem valóban skálázható infrastruktúra legyen.